Verwalten Sie alle Ihre digitalen Workflows und halten Sie Ihre Daten immer aktuell

Automatisierte digitale Arbeitsabläufe sind der Schlüssel zu effizienten und erfolgreichen Geschäftsprozessen: Abteilungen können sich auf die wichtigen Entscheidungen konzentrieren und haben immer die neusten Berichte zur Verfügung, analytische Dashboards zeigen aktuelle Informationen an und Vorhersagemodelle werden mit den bestmöglichen Daten trainiert. Verfügbarkeit und Nachvollziehbarkeit von Daten sind entscheidend für das Vertrauen in datengesteuerte Entscheidungsfindung und Planung. Vertrauen Sie auf die weltweit beliebteste Open-Source-Plattform zur Workflow-Orchestrierung, damit Ihre Workflows wie am Schnürchen laufen: Apache Airflow.

Apache Airflow ist das führende Open-Source-Framework für die Workflow-Orchestrierung. Es führt die zeitkritischen Prozesse und Datenpipelines von Hunderten von Unternehmen weltweit aus, darunter Pioniere des datenzentrierten Geschäftsmodells wie AirBnB, Pinterest, Spotify oder Zalando. Die Software-as-a-Service-Giganten AWS und Google Cloud Platform bieten Airflow als Teil ihres regulären Servicekatalogs an, und Astronomer hat sogar sein ganzes Produkt und Unternehmen um das Open-Source-Projekt herum aufgebaut.

Der Erfolg von Airflow beruht auf den Grundprinzipien des Projekts: Skalierbarkeit, Erweiterbarkeit, Dynamik und Eleganz. Die modulare Microservices-Architektur, die auf der Programmiersprache Python basiert, eignet sich für alle technischen Anforderungen, die auftreten können. Die Definitionen der Arbeitsabläufe in Airflow werden in Python-Code ausgedrückt, wodurch das System für jeden, der über etwas Programmiererfahrung verfügt, leicht zu erlernen ist. Da Airflow kein spezielles Datenpipeline-Tool ist, sind der Automatisierung von Geschäftslogik mit dem System keine Grenzen gesetzt. Das erweiterte Airflow-Ökosystem bietet Konnektor-Bibliotheken für fast alle denkbaren Systeme von Drittanbietern, darunter AWS, Azure, Oracle, Exasol, Salesforce und Snowflake. NextLytics kann Ihnen sogar eine SAP-Integration bieten! Und nicht zuletzt sind aufgrund der freien Apache-Softwarelizenz keine Lizenzgebühren oder Anbieterbindung zu befürchten.

Zuverlässige Workflow-Orchestrierung ist eine absolute Notwendigkeit für die digitale Organisation. Lesen Sie weiter oder laden Sie unser Whitepaper herunter, um mehr darüber zu erfahren, wie Airflow zum anhaltenden Erfolg Ihres Unternehmens beitragen kann und wie NextLytics Sie auf diesem Weg unterstützen kann.

Digitale Workflows mit der Open-Source Plattform Apache Airflow

Erweiterte Arbeitsabläufe in Python erstellen

In Apache Airflow werden die Workflows mit der Programmiersprache Python erstellt. Die Einstiegshürde ist niedrig. In wenigen Minuten können Sie selbst komplexe Workflows mit externen Abhängigkeiten zu Drittsystemen und bedingten Verzweigungen definieren.

![]()

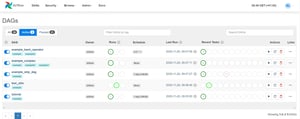

Workflows planen, ausführen und überwachen

Die programmgesteuerte Planung, Ausführung und Überwachung von Workflows verläuft dank des Zusammenspiels der Komponenten reibungslos. Leistung und Verfügbarkeit lassen sich an Ihre anspruchsvollsten Anforderungen anpassen.

![]()

Bestens geeignet für Machine Learning

Hier werden Ihre Anforderungen an Machine Learning optimal erfüllt. Selbst ihre komplexen Workflows können mit Apache Airflow ideal orchestriert und verwaltet werden. Die unterschiedlichen Anforderungen an Software und Hardware können problemlos umgesetzt werden.

![]()

Zuverlässige Orchestrierung von Drittsystemen

Bereits in der Standardinstallation von Apache Airflow sind zahlreiche Integrationen zu gängigen Drittsystemen enthalten. So können Sie im Handumdrehen eine robuste Anbindung realisieren. Ohne Risiko: Die Verbindungsdaten werden verschlüsselt im Backend gespeichert.

![]()

Ideal für den Unternehmenskontext

Die Anforderungen von Start-ups und großen Unternehmen werden durch die hervorragende Skalierbarkeit gleichermaßen erfüllt. Als Top-Level-Projekt der Apache Software Foundation und mit ihren Ursprüngen bei Airbnb war der wirtschaftliche Einsatz im großen Maßstab von Anfang an vorgesehen.

![]()

Ein Blick in die umfangreiche intuitive Weboberfläche

Ein wesentlicher Vorteil von Apache Airflow ist das moderne, umfangreiche Webinterface. Mit rollenbasierter Authentifizierung liefert die Oberfläche Ihnen einen schnellen Überblick oder dient als einfacher Zugriffspunkt für die Verwaltung und das Monitoring der Workflows.

Die Orchestrierung von Drittsystemen wird durch zahlreiche bestehende Integrationen realisiert.

- Apache Hive

- Kubernetes-Engine

- Amazon DynamoDB

- Amazon S3

- Amazon SageMaker

- Databricks

- Hadoop Distributed Filesystem (HDFS)

- Bigtable

- Google Cloud-Storage (GCS)

- Google BigQuery

- Google Cloud ML Engine

- Azure Blob Storage

- Azure Data Lake

- ...

Die Workflowmanagement-Plattform für Ihre Anforderungen

‣ Flexibilität durch benutzerdefinierte Individualisierung

Die Anpassungsfähigkeit ist durch zahlreiche Plugins, Makros und individuelle Klassen gegeben. Da Airflow vollständig auf Python basiert, ist die Plattform theoretisch bis in die Grundlagen veränderbar. Passen Sie Apache Airflow jederzeit an Ihre aktuellen Bedürfnisse an.

‣ Vollständig skalierbar

Eine Skalierung mit gängigen Systemen wie Celery, Kubernetes und Mesos ist jederzeit möglich. In diesem Zusammenhang kann eine leichtgewichtige Containerisierung installiert werden

‣ Völlig kostenlos

Die Workflow-Management-Plattform ist ohne Lizenzgebühren und mit minimalem Installationsaufwand schnell verfügbar. Sie können immer die neuesten Versionen in vollem Umfang nutzen, ohne dass Gebühren anfallen.

Als De-facto-Standard für Workflow-Management umfasst die Airflow Community nicht nur Anwender, sondern die Plattform profitiert auch von engagierten Entwicklern aus aller Welt. Aktuelle Ideen und deren Umsetzung in Code sind online zu finden.

‣ Agilität durch Einfachheit

Die Workflow-Definition wird durch die Implementierung in Python stark beschleunigt und die Workflows profitieren von der gebotenen Flexibilität. In der Web-Oberfläche mit hervorragender Usability können Fehlerbehebungen und Änderungen an den Workflows schnell umgesetzt werden.

Modernes Workflow-Management mit Apache Airflow 2.x

- Voll funktionsfähige REST-API mit zahlreichen Endpunkten für die Zwei-Wege-Integration von Airflow in verschiedene Systeme wie SAP BW

- Funktionale Definition von Workflows zur Implementierung von Datenpipelines und verbesserter Datenaustausch zwischen Aufgaben im Workflow mit der TaskFlow-API

- Just-in-time-Planung auf der Grundlage der Erkennung von Änderungen oder der Verfügbarkeit der erforderlichen Datenelemente

- Dynamische Aufgabenerstellung und Skalierung auf Basis von Metriken des aktuellen Datenflusses

- Verbesserte Überwachung der Geschäftslogik durch Integration mit Data-Observability-Frameworks

- Erhöhte Benutzerfreundlichkeit in vielen Bereichen (vereinfachter Kubernetes-Operator, wiederverwendbare Aufgabengruppen, automatische Aktualisierung der Weboberfläche)

Apache Airflow im Tagesgeschäft

![]()

Automatische Dateiübertragung

Durch die Vielzahl von Integrationen zu anderen Systemen kann der Transfer von Daten und Dateien einfach realisiert werden. Über so genannte Sensoren werden in regelmäßigen Abständen Startbedingungen wie das Vorhandensein einer Datei überprüft. So kann beispielsweise eine CSV-Datei aus dem Cloud-Service in eine Datenbank geladen werden. Auf diese Weise können unnötige manuelle Arbeiten automatisiert werden.

![]()

Ansteuerung von externen Prozessketten über API

Auch wenn es keinen einfachen Weg zur Systemintegration per Task-Operator gibt (und die Community noch keine Lösung bereitgestellt hat), ist die Anbindung über APIs und HTTP-Requests jederzeit möglich. So kann z.B. eine Prozesskette im SAP BW synchron gestartet und verfolgt werden. Umgekehrt ist die Systemintegration über Airflows hervorragende API problemlos möglich.

![]()

Ausführen von ETL-Workflows

Ihr Datenmanagement wird am meisten von Apache Airflow profitieren. Noch nie war es so einfach, unterschiedliche strukturierte Datenquellen in einer Zieltabelle zusammenzuführen. Ursprünglich wurde Airflow speziell für die Bedürfnisse von Extract-Transform-Load (ETL) Workflows entwickelt und bietet intelligente Konzepte wie wiederverwendbare Workflow-Teile, um auch komplexe Workflows schnell und robust zu erstellen.

![]()

Machine Learning Prozesse implementieren

Nicht nur bei der Entwicklung einer Machine Learning Anwendung gibt es viele Prozesse, die idealerweise als Workflow implementiert werden. Auch die produktive Ausführung eines Modells kann als Workflow implementiert werden und so z.B. aktuelle Prognosedaten in festen Intervallen bereitstellen. Die Datenaufbereitung und das Training der aktuellen Modellversion kann mit Airflow einfach realisiert werden.

Unsere Dienstleistungen:

-

Betrieb

-

Implementierung

-

Entwicklungspartner in der Cloud oder vor Ort

-

Unternehmensunterstützung

-

Maßgeschneiderte Dienstleistungen

Möchten Sie mehr über Machine Learning erfahren?

In unserem Blog finden Sie weitere interessante Artikel zu diesem Thema

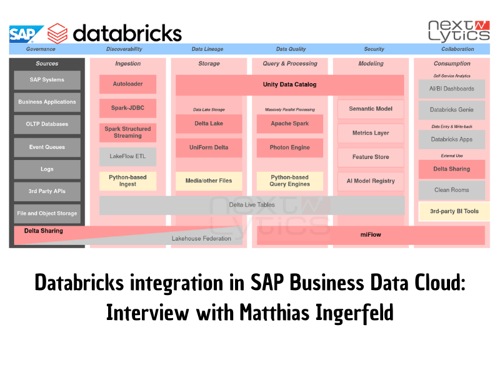

Databricks integration in SAP Business Data Cloud: Interview with M. Ingerfeld

In February 2025, SAP and Databricks finally announced tangible results from their 2-year-long...

Business Data Cloud - What is it all about?

Yesterday we saw SAP present their long awaited announcement at the SAP Business Unleashed 2025...

Data Platform Architecture with SAP Datasphere & Databricks

As digitalization advances, the amount of data that companies have to process is growing, along...